本部要闻 来源:中译语通日期:2024-02-21浏览次数:933

日前,中译语通“格物”大模型又实现新突破,GeWuMT-18B模型以机器翻译任务为导向,支持在81个语种之间互译,经专业评测,相较于Meta发布的NLLB-54B模型,格物仅使用了其三分之一的参数量规模,实现了在以中文为目标语言的80个语种的自动评测中平均BLEU值提升超过27%,无论是翻译的流畅性还是准确度,大模型的翻译结果质量又得到了进一步提升。

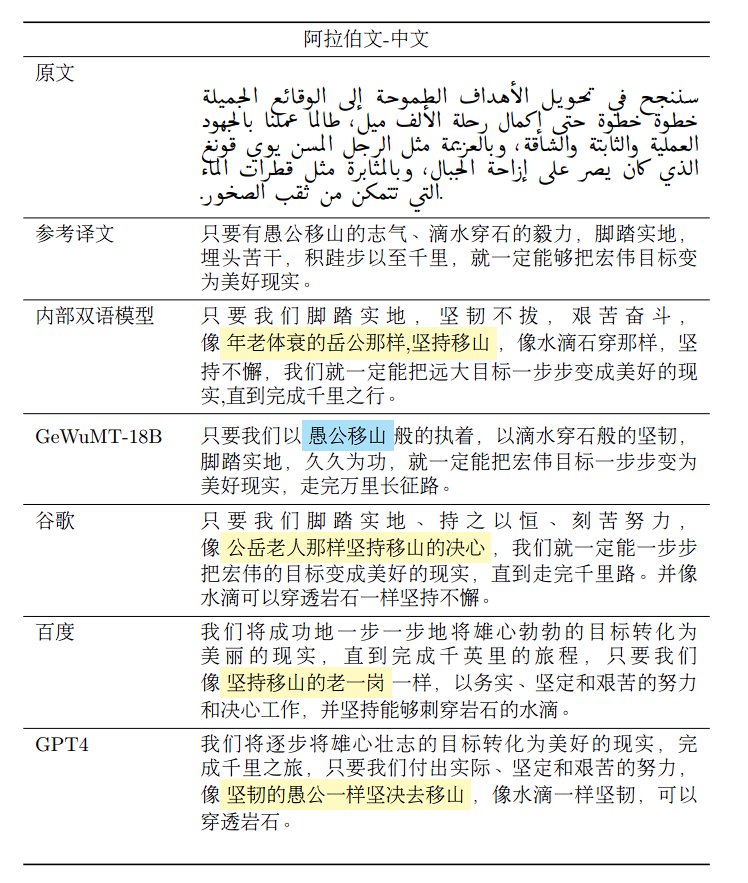

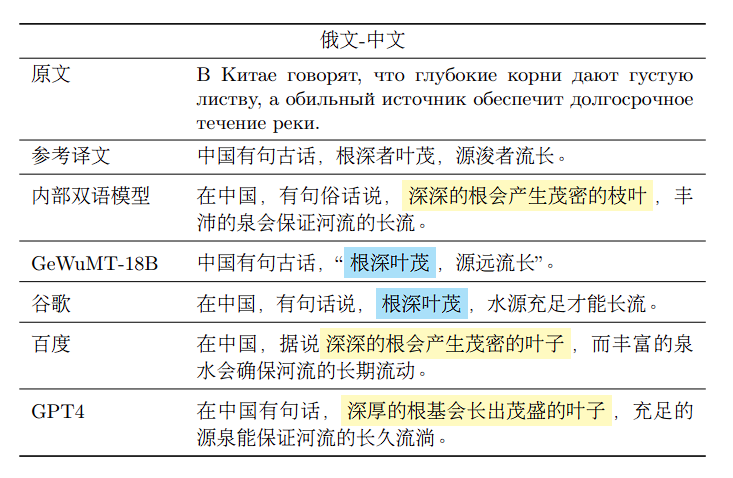

GeWuMT-18B模型翻译效果与其他在线翻译引擎比较,测评结果如下:

GeWuMT-18B机器翻译大模型除了在翻译准确度上有明显提升外,对系统运维复杂度和运行的资源需求均有明显的提升。既往的机器翻译引擎每一个语言方向是一个单独的模型,支持80个语种到中文的翻译需要部署80套引擎,大模型实现了一个单一模型支持80个语种到中文的翻译,大大减少了用户使用期间运维支持的工作难度。GeWuMT-18B大模型可以运行在一块80G显存的GPU卡上,实现单机支持80个语种同时运行,对比支持80个语种的双语模型在存储空间和计算资源消耗上至少节省了80%,大大降低了运行成本。

GeWuMT-18B机器翻译大模型实现了技术的完全自主可控,摆脱对国外商用机器翻译模型的依赖,提升了数据安全性,尤其是对国防军事、金融、科技等敏感领域意义重大。同时对于构建自主可控的语言生态体系,提升国家文化软实力也有着重要意义。大模型针对特定任务和语种进行定制化训练,翻译质量显著提升,满足垂直领域的高精度翻译需求。

中译语通团队深入分析了包括GPT4、Google Gemini、NLLB-54B等在内的多个大模型的成功之处,并在自主可控的机器翻译大模型上进行了一系列不懈的技术创新尝试。对所用数据以及训练方法进行优化,显著提升了模型的翻译能力。

与其他在线翻译引擎不同,本次中译语通发布的GeWuMT-18B模型在训练方法上,采用了基于MoE(混合专家模型)的Transformers encoder-decoder框架,为容纳80个外文语种共设置了40个专家,在鲁棒性、分布式训练、多语言增量训练等技术上都取得了一定的突破。基于交叉熵对训练数据进行重采样,确保在每一个数据分片上的训练均有一定的正向收益。再者,训练数据也是决定大模型质量好坏的关键因素之一,借助中译语通拥有的国内最大高质量平行语料库的优势,在百亿平行语料和千亿单语数据库中进行精选,最终精调使用了约40亿高质量平行语料与单语数据用于此次新模型的训练。

为了保证质量与效能我们使用了多种训练和调优方式:

星环状混合专家系统

混合专家系统在训练过程中,会有大量时间开销花费在all-to-all通信中,为了进一步缩短训练时间,提升训练效率,中译语通提出了星环状混合专家系统结构,在保障模型训练精度的同时,大大降低all-to-all通信。混合专家系统的引入,提升了模型的容量,同时也利用多语言模型的知识迁移能力,既能保证资源丰富语种翻译性能,又能提升资源稀缺语种的翻译质量。

无监督学习

GeWuMT-18B模型覆盖了包括中文在内的81个常用语种,在这些语种中,不乏如古吉拉特语、马耳他语等低资源的语种,数据资源的缺失直接会使得模型在相关的语言方向上学习不足,导致以该语种为目标语言的译文困惑度较高,甚至出现翻译脱靶(Off-Target)的错误。为了解决这些问题,GeWuMT-18B模型在进行机翻任务训练的同时,利用无监督学习在选定单语数据上进行针对性的单语任务训练,强化模型对低资源语种的语言理解能力,有效降低了低资源语种译文的困惑度,大幅度提升了中到外方向上低资源语种的翻译质量。

数据采样

针对海量数据GeWuMT-18B模型还采用了数据分片训练的策略,为了平衡每个数据分片,凭借基于温度和训练交叉熵的混合采样策略,确保每个数据分片均能对模型训练起到积极作用。这种数据采样的方法,降低了对硬件显存和内存的需求,同时也便于针对训练的效果及时调整训练数据。

中译语通自2014年启动机器翻译的研发工作,持续致力于自主可控的人工智能机器翻译引擎研发,历经了统计机器翻译、神经机器翻译到今天基于大模型的机器翻译。在2020年承担了科技部2030重大专项“以中文为核心的多语种自动翻译研究”,在2021年承担了工业和信息化部揭榜挂帅任务“超大规模多语言通用机器翻译系统”,同时也承担了云南省科技厅的“以中文为核心的超大规模神经机器翻译模型研究及产业应用”项目。基于这三个项目形成的相关经验为中译语通在超大规模多语言机器翻译技术方面积累了坚实的技术基础。在WMT2022和2023年度的评测中,以大规模多语言模型为基础,累计获得了7个语言方向的自动评测冠军,在行业中名列前茅。

中译语通于2021年启动研发跨语言、多模态大模型技术,并在2022年11月发布“格物”大模型。该大模型涵盖了四种模型,包括多语言预训练模型、多语言机器翻译超大模型、多模态预训练模型和多语言生成式对话大模型。中译语通“基于多模态思维链推理的可控内容生成大模型技术研究及示范应用”课题主要针对中文文本、图像、音频和视频四模态对齐语料匮乏、四模态单一模型架构能力受限、应用时效性差等问题,突破多模态思维链的内容理解与可控生成技术,研发支持基于多模态思维链的四模态任意模态输入输出大模型,并在国防、政务、科技和金融等领域开展示范应用。同时,中译语通参与了《大规模预训练模型技术和应用评估方法 第一部分:模型开发》、《大规模预训练模型技术和应用评估方法 第二部分:模型能力》和《大规模预训练模型技术和应用评估方法 第四部分:模型应用》的标准起草编制工作。

2024年1月,中译语通连续第三次被美国国防部列入“中国涉军企业”制裁清单。这更坚定了公司在人工智能领域创新发展的决心。中译语通将进一步加大在大模型数据和基础研发的投入,并致力于大模型的行业落地以及国产化适配,为国防军事、国家安全和政府等关键领域用户构建可适应复杂场景的自主、安全、可信的私有大模型技术与应用,持续铸造国家战略科技力量。